最近、歌う人工知能に関心を寄せる研究者が多いという。歌うという行動は、楽譜に合わせて声を出すようにさえすればよいように見えるが、曲に対する解釈や表現能力が必要とされ、実際には高度な知識が要求される。

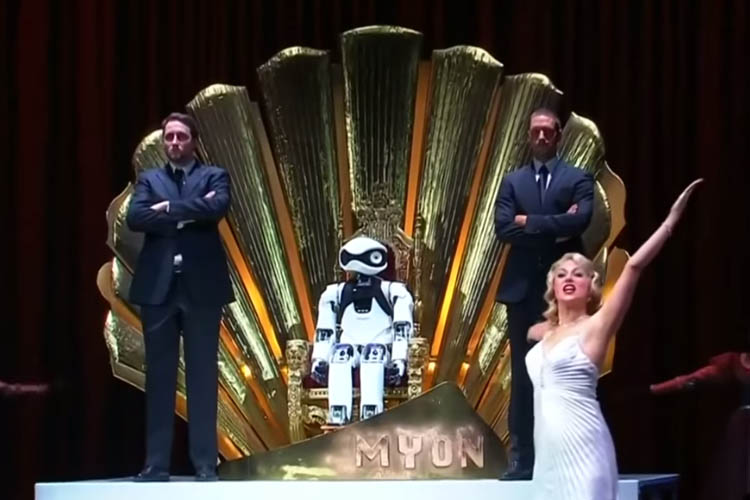

最近では、コンピュータ自らの判断で音を自在に合成し、人間のように歌う技術が開発されはじめている。 2015年7月、ドイツ・フンボルト大学の研究チームが開発したヒューマノイドロボット・ミオンは、ベルリンの芸術家集団とともにオペラの舞台にのぼり、観客を驚かせた。

ミオンには、ベルリン・ボイト工科大学電子工学科、マンフレッド・ヒルド(Manfred Hild)教授チームが開発した人工知能プログラムが搭載されている。同プログラムは音符と歌詞を解釈し、その後必要な声を合成して歌う。これは、「統計的音声合成」と呼ばれる技術である。

ミオンの歌の実力は、日本のヤマハが開発したボーカロイドよりも、まだまだ劣るという評価がある。機械音のように、音節をきちんと区切り発音も不自然。とはいえ、専門家たちは、ミオンのような人工知能で歌う技術が、一層発展していく可能性が高いと見ている。背景に、歌の実力に不可欠な言語分野の人工知能が、飛躍的に発展しているという実情があるからだ。

囲碁AI・アルファゴで有名な英企業グーグルディープマインドは9月9日、「ウェーブネット」という音声合成技術を公開した。この技術は、ミオンに使われたものと似たものであるが、現在までに世に出た音声合成技術のなかで、最も人間に似ているという評価を受けている。必要に応じて、英語の発音をイギリス式、アメリカ式など、自由に変えることもできるという。

韓国IT大手・カカオも、2014年に人工知能で文字を読み取る「ニュートントーク」というプログラムを開発したことがあるが、パフォーマンスはウェーブネットに比べて劣る。その差のひとつには、音の「細分化」がある。ウェーブネットは、音声合成ユニットをはるかに細かく分けて合成するので、人とほぼ同じ声を出せる。