アルゴリズムによる「自動化された不平等」に対し、懸念が高まっている。アルゴリズムが下した判断は、個人を刑務所に送ることも、労働市場の敗者にすることもできるようになりつつある。これと関連したさまざまな兆候があるが、そのうちふたつをまず紹介したい。

・米国の24の州の裁判所では、判決参考資料として再犯危険性モデルを活用している。犯罪者が再犯する危険性を測定するのに役立つと思われるいくつかのデータや仮定をもとに、アルゴリズムを開発したのだ。受刑者たちは「初めて警察に捕まったのは何歳だったか」「友人や親戚には前科があるか」などの質問に答えなければならない。所得水準が低くスラムに住んでいる黒人の多くは、それらの問いに「はい」と答える確率が高い。結果、黒人の再犯確率は高いと測定されざるを得なくなる。アルゴリズムはその際、人間の偏見を取り除くよりも、技術で覆い隠してしまう。

・2001〜2002年、シカゴ大学とMITの共同研究者は、求人広告を出している約1300の企業に、5000枚の“偽の履歴書”を送った。それぞれの履歴書には、人種的差が明確に見て取れる内容が含まれていた。履歴書の半分には典型的な白人の名前を、残りの半分には典型的な黒人の名前を書いた。そのほかの条件はすべて同じだった。結果、白人の名前を使用した履歴書の反応率は、黒人の名前の履歴書のそれより50%高かったという。米国では、履歴書を機械的に審査するシステムが普及している。アルゴリズムは履歴書を処理しつつ、企業が希望する技術と経験を選び出し、各職務と適合スコアを付ける。履歴書の72%は機械で処理されるので、人間の担当者の審査を受ける機会さえ与えられない。

現在、メディアなどは検索されやすくするように、検索エンジンに適したWebページを設計する必要に迫られているが、上記ふたつの例以外にも、人間は「機械を説得する能力」を強く求められ始めている。そのような状況から、米国の数学者データ科学者であるキャシー・オニール氏は、著書「Weapons of Math Destruction」で冒頭のふたつの例を挙げ、アルゴリズムとビッグデータが不平等を拡散し、民主主義を脅かす可能性を指摘している。

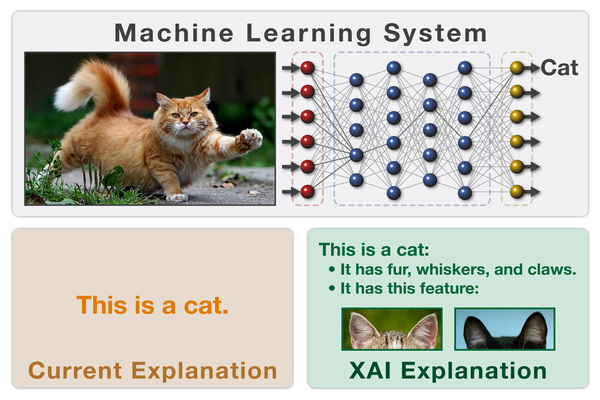

ディープラーニングなど、ここ数年大きな進歩を遂げた技術は、結果だけ知らせ、どんな根拠で判断にいたったのか論理的に説明できないという点が限界として指摘されている。いわゆる「ブラックボックス問題」だ。そのような課題を持った技術を、犯罪危険性の判断や人事評価、軍事作戦、医療分野などに適用すれば効率は向上するだろうが、公正性と正確性を確保する、もしくは公正性と正確性を人間が理解することは難しくなる。そこで注目を浴びているのが、「説明可能な人工知能」(Explainable AI、以下XAI)である。